2024年3月28日至29日,“CAIR香港人工智能与机器人医疗论坛”在香港科学园举行。论坛由中国科学院香港创新研究院人工智能与机器人创新中心主办,聚焦人工智能与机器人在医疗领域的创新应用。来自全球的

来源标题:复古票根背后的魔力——年轻人涌入爷爷奶奶的电影院 一家影院,在电影节期间能有多让人眼前一亮?如果你问曹杨影城,答案是:能让你感受到电影的温度和人情味。这座始建于1960

来源标题:华语歌声越南洋|《音你而来2》圆满收官:跨文化传播综艺的新范式 “行山海,玩音乐,觅知音”,在全球文化交流日益频繁的当下,以音乐为纽带打破文化隔阂、突破娱乐边界,探访

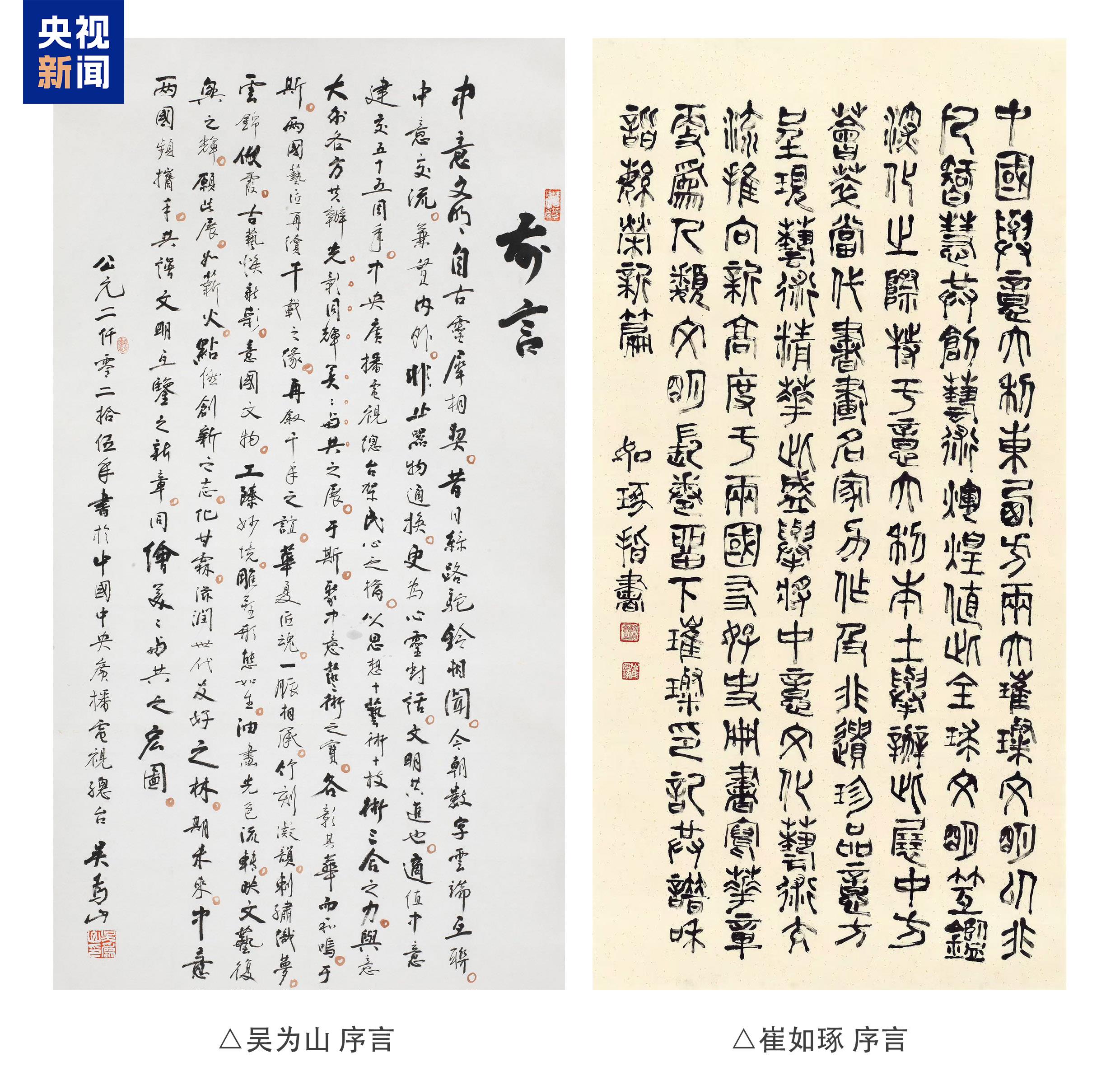

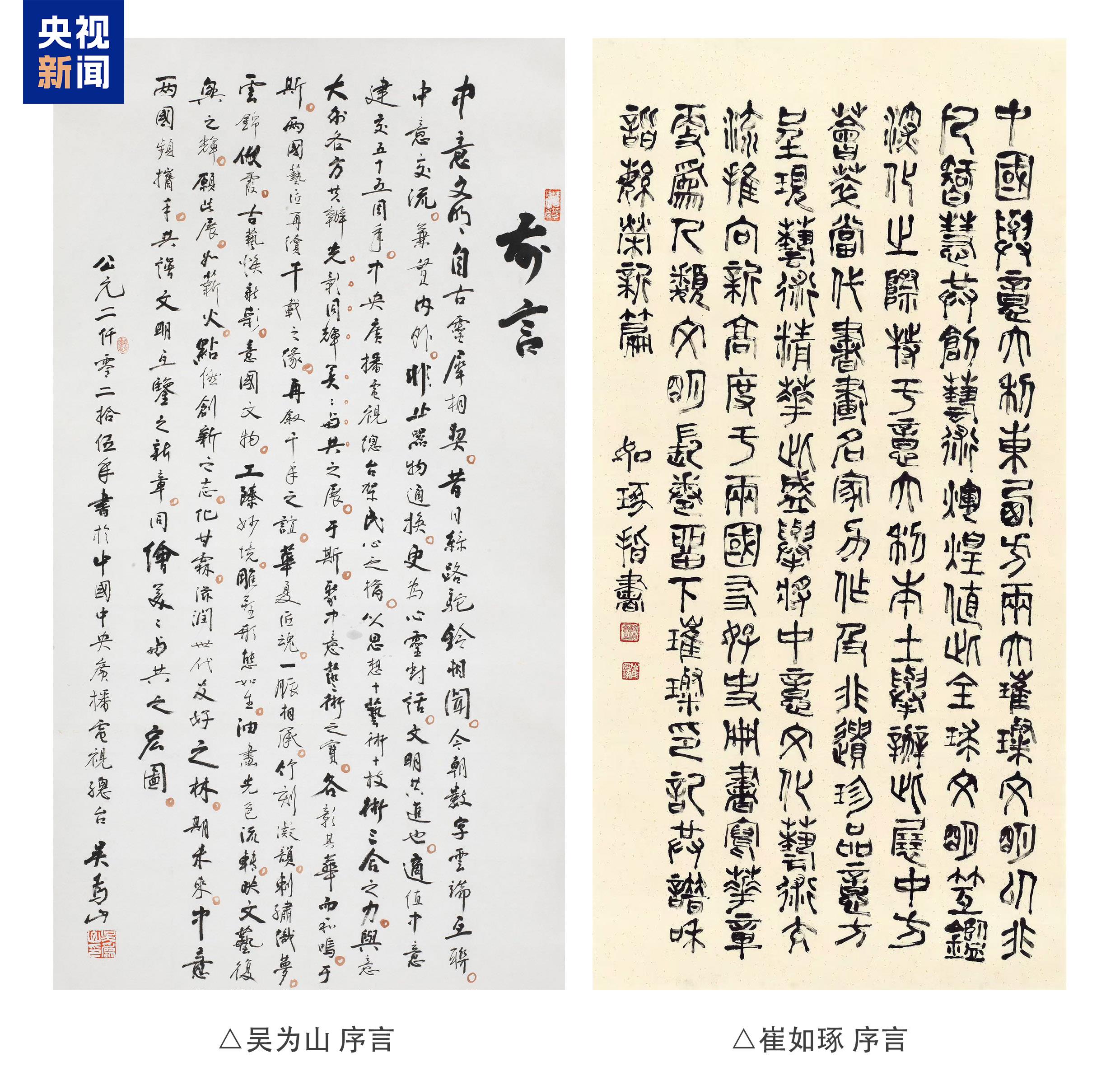

来源标题: 准备就绪!“光影同辉 美美与共”——庆祝中意建交55周年艺术特展即将开幕当地时间6月24日,由中国中央广播电视总台联合意大利文化部、意大利人类文明博物馆、意大利罗马美术学院、意大利足球协会

7月9日,歌手周杰伦正式入驻抖音,开通了他第二个中文社交媒体账号,取名“周同学”,头像是他的玩偶形象。抖音称“花9位数签周杰伦”不属实。

来源标题:《五哈5》南北对抗火药味拉满!王祖蓝88米蹦极立十年之约,兄弟情深笑点连连《哈哈哈哈哈》第五季以下简称《五哈5》)第十一期如约上线,五哈团成员邓超、陈赫、范志毅、王勉与李乃文、任重、王祖蓝、

来源标题:制片人罗文强再推力作《我的爸爸是小学生》:腾讯独播暖心治愈,探讨亲子关系新维度2019年,资深制片人罗文强再度操盘亲情题材电影《我的爸爸是小学生》,用光影艺术深入当代家庭情感核心。这部由他倾

来源标题:电影《超人》启动#我身边的超人瞬间#线上征集没有人天生是英雄,只有凡人的无畏与勇往;没有人自带超能力,却会在某个瞬间进发超人般的守护力量。或许是你深陷无助时伸过来的那双手;或许是你濒临崩溃时

来源标题:《沙丘:觉醒》揭晓游戏中后期体验内容Funcom最近的直播活动展示了为PvE和PvP玩家提供的丰富机制与体验内容《沙丘:觉醒》6月5日抢先体验即将开启6月10日正式全面上线)。近期,开发商F

来源标题:爱奇艺国际版将与SBS Studio Prism携手制作泰国版《Running Man》6月24日,爱奇艺国际版宣布与韩国SBS旗下知名制作公司Studio Prism正式签署国际合作备忘录

来源标题:第三届浪潮创作人论坛在京举行,共同探讨AI共创时代的创新音乐叙事由浪潮评委会发起、腾讯音乐娱乐集团(TME)主办的第三届浪潮音乐大赏于6月19日在北京盛大开启。6月18日,2025浪潮创作人

来源标题:阿比亚斯献唱“歌游内蒙古” 北疆文化活动季主题演出 在 “歌游内蒙古”北疆文化活动季主题演出的舞台上,草原新生代青年歌手阿比亚斯凭借独特的音乐魅力打动现场近3万名观众